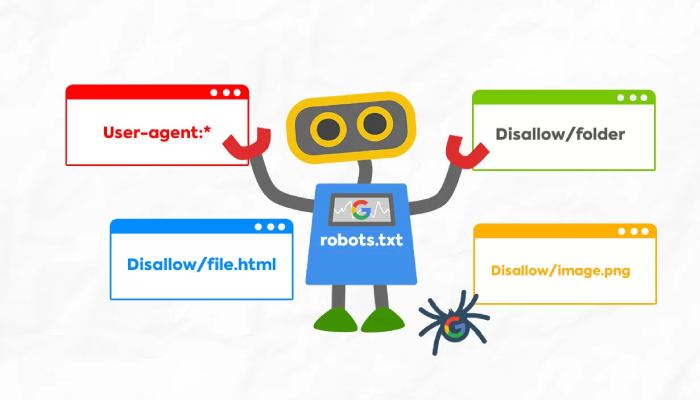

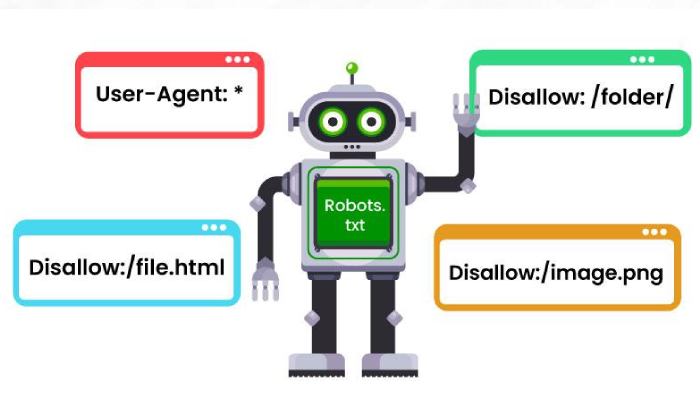

Robots.txt و سئو ، موضوعی است که در ارتباط با آن صحبت می کنیم و توضیحات مفیدی را درباره ارتباط آنها بیان می کنیم.

Robots.txt، نقش مهمی در سئو دارد و باید با نحوه استفاده از آن آشنایی داشت. این پروتکل از سال 1994 یک استاندارد وب به شمار می آید و امروزه، ابزاری برای بهینه سازی وب سایت ها می باشد و در راستای سئو سایت مورد استفاده قرار می گیرد. این پروتکل در واقع سبب تعامل بهتر موتورهای جستجو و دیگر ربات ها با یک وب سایت می شود.